使用VSCode+clangd插件配置C项目IDE环境

本文将介绍如何在 WSL2 环境下,利用 VSCode 结合 clangd 插件,构建一个能够高效美观地阅读大型 C 项目的 IDE 环境。clangd 插件版本为 0.4.0,本地 clangd 后端版本为 18.1.3。 基本配置WSL2 配置的基本流程如下所示: (如果启用)禁用 Microsoft 的 C/C++ 扩展中的 IntelliSense 功能,防止冲突。 扩展应用商店安装 clangd 插件。 在 WSL2 中安装 clangd 后端:sudo apt install clangd。 创建 compile_commands.json。 在项目根目录下创建 .clangd 配置文件进行进一步调整。 在此简单解释一下 compile_commands.json 和 .clangd 配置文件的作用:compile_commands.json 存储着项目的编译命令,clangd 正式根据该命令列表推断出不同源代码之间的关系,实现符号跳转的功能;而 .clangd 则相当于一个“微调选项”,对项目的 clangd 分析工具进行进一步调整。 接下来,我将介绍我平常接...

Linux文件系统的设备ID

本文将介绍 Linux 文件系统中的文件的设备 ID 相关内容,基于的内核版本为 6.18。 为了介绍设备 ID 的概念,我们借助 stat 工具来对打印几个不同类型文件的元数据信息。 首先是一个位于磁盘文件系统下的普通文件 file.txt: 12345$ stat file.txt File: file.txt Size: 392 Blocks: 8 IO Block: 4096 regular fileDevice: 8,80 Inode: 16473 Links: 1... 可以看到,其 Device 编号为 8,80,具体含义我们后面再解释。 接下来要查看的是伪文件系统(如 ramfs、procfs 等没有直接关联的磁盘设备的文件系统)下的文件元数据信息,由于我的本地 Linux 环境是 WSL2,因此这里我选取了挂载在 Linux 下的 Windows 磁盘:/mnt/d,顾名思义,它就是我 Windows 系统下的 D 盘。WSL2 通过 9p 协议将 Windows 磁盘挂载到 Linux 下,...

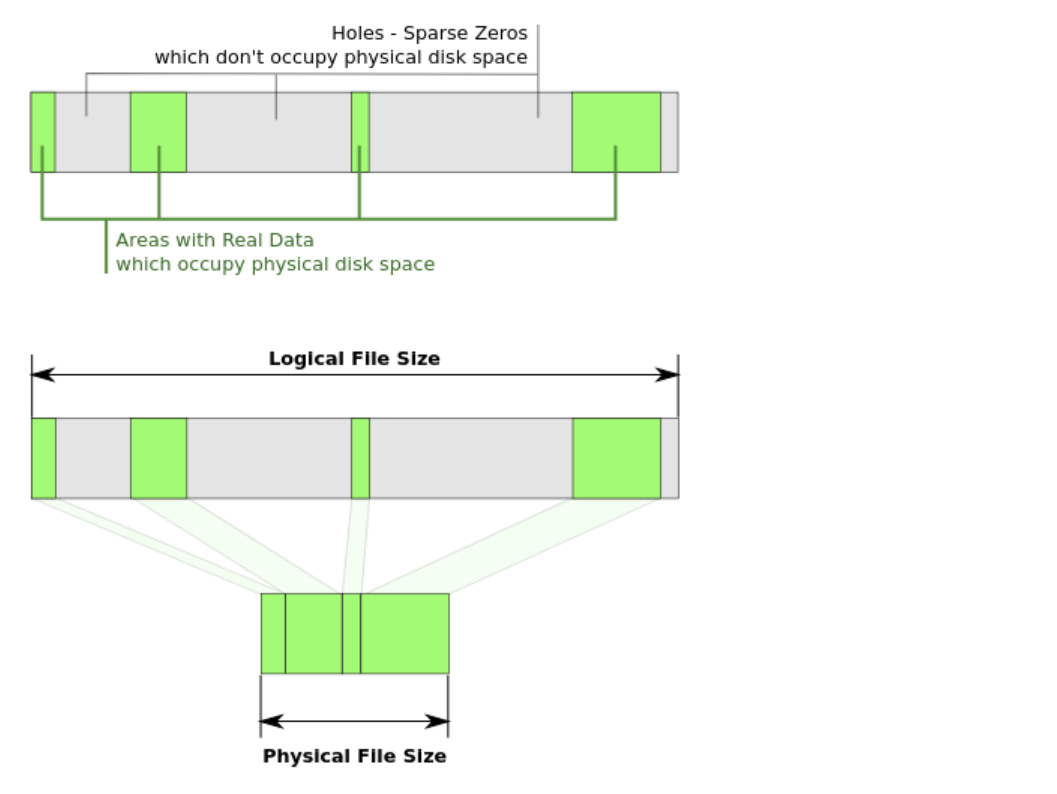

使用debugfs分析Ext2下的稀疏文件

本文将介绍 Ext2 文件系统下的稀疏文件表示,并使用 debugfs 对其进行分析。 环境准备12345678910111213141516# 创建一个 2G 大小的 Ext2 磁盘镜像文件dd if=/dev/zero of=ext2.img bs=1M count=2048# 生成一个 8M 大小的全零文件(非稀疏)dd if=/dev/zero of=8M.zero bs=1M count=8# 创建一个 8M 大小的 Ext2 格式化的镜像文件(稀疏)cp 8M.zero 8M.ext2mkfs.ext2 -F 8M.ext2# 将两个 8M 大小的文件拷入 ext2.img 中mkdir -p tmpsudo mount ext2.img tmpsudo cp 8M.zero tmpsudo cp 8M.ext2 tmpumount tmp 稀疏文件的本质稀疏文件即一个文件的起始位置到结束位置之间存在“空洞”(如下图所示),所谓空洞,就是该文件区域没有被分配任何的磁盘空间,体现在 Ext2 文件系统元数据的层面就是——对应的数据块指针为空。 更形式化的描述为:只要...

个人常用git命令整理

由于最近刚刚快速过完了一遍《Pro Git》,因此想要将个人比较常用的 git 命令整理出来,以便需要时翻看。因此本文是一个个人向的笔记,不会涉及对 git 原理的介绍,这部分的具体内容可以参考《Pro Git》。 准备阶段初始化配置12345678# 全局配置文件位置~/.gitconfig# 全局配置用户名git config --global user.name <your_name># 全局配置邮箱git config --globale user.email <your_email> 新建仓库12345# 本地初始化仓库git init <repo_name># 远程克隆仓库git clone <repo_url> 工作阶段查看日志123456789# 查看当前分支提交日志git log# 查看 HEAD 指针的变动日志git reflog# 查看当前仓库状态# 包括未跟踪文件、工作区变更、暂存区内容git status 提交文件123456789# 将工作区更新文件存入暂存区git add <file_path&...

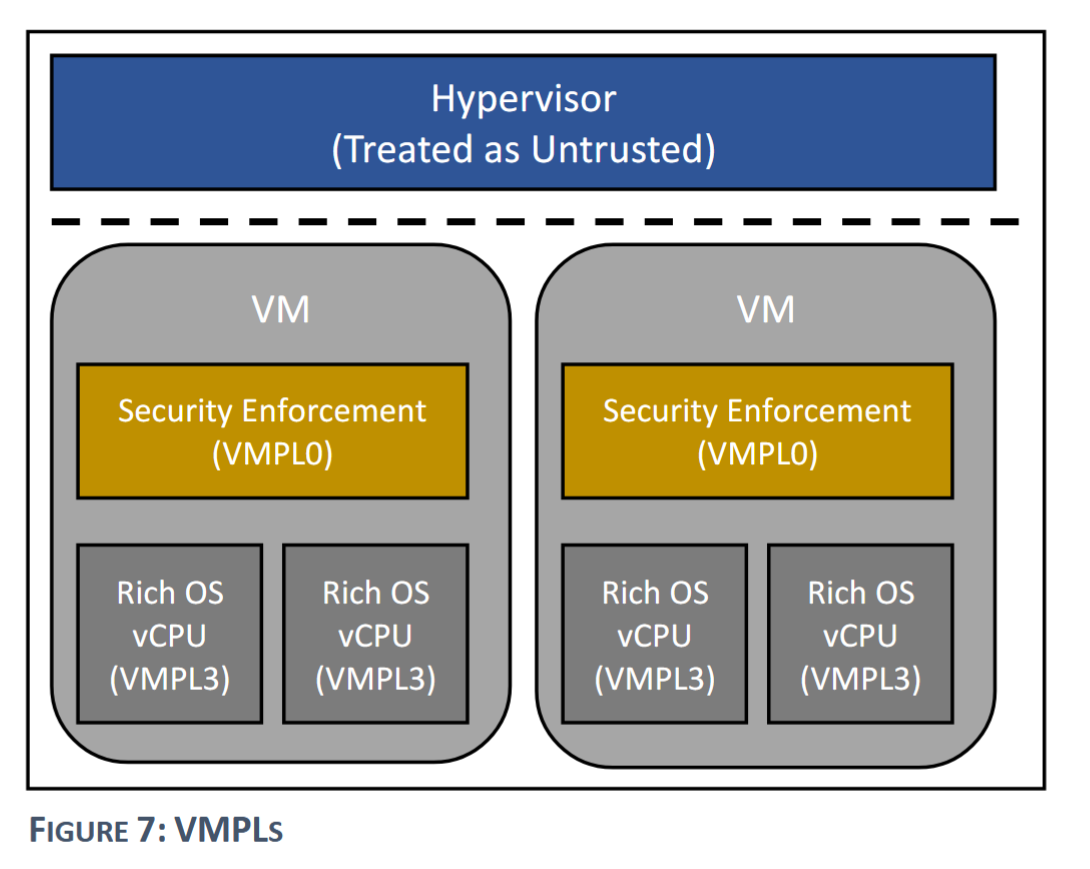

现有机密虚拟机设计方案汇总

本文算是一个笔记性质的文章,整理了现有的大部分机密虚拟机(CVM)的设计方法,并主要围绕硬件/固件扩展、内存机密性保护、内存完整性保护、寄存器状态保护几个方面来介绍。覆盖了市面上的大多数 CVM 设计,既包括工业界已商用的方案,如 AMD SEV、Intel TDX 等,也包括一些学术界的方案,如 VirTEE、ZION。 由于 Arm 官方方案 CCA 的标准和软件栈趋近成熟,因此基于 Arm 架构的其它方案如 TwinVisor 和 virtCCA 在此便不再介绍了,以下是个人整理的现有 CVM 方案的列表: AMD SEV-SNP: 现已商用。 Intel TDX: 现已商用。 Arm: TwinVisor (SOSP ‘21): None virtCCA (arXiv): None CCA (官方方案): 硬件规范成熟,软件栈快速构建中,支持的芯片(Arm v9)还未上市。 IBM PEF: 现已商用,发表论文(EuroSys ‘21)。 RISC-V: CoVE: 社区官方方案,正在建设中 VirtTEE (DAC ‘22): 向下兼容,虚拟机内核无需经过修改。...

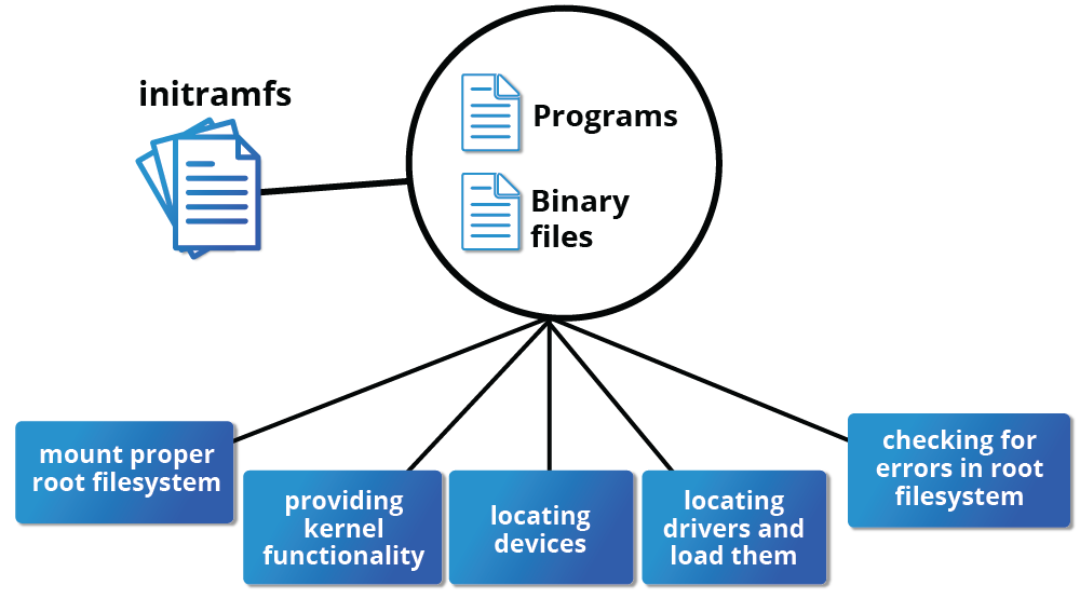

浅谈rootfs、initramfs和initrd

本文算是之前博客 使用QEMU安装并启动一个Ubuntu发行版 | Lordaeron_ESZ’s blog 的一个 callback,花了一天时间整理了一下有关 rootfs、initramfs 等操作系统启动相关的内容,并在此分享出来。 rootfs首先需要理解 rootfs(即根文件系统)的概念。本质上来说,rootfs 就是挂载在根目录(/ 目录)上的文件系统,而无关具体的文件系统类型。 另外,rootfs 根据系统启动时刻的不同,分为两个阶段,一阶段为系统启动初期的内存 rootfs(通常为 ramfs 和 tmpfs,下面将具体介绍),二阶段为完成基本的模块加载等操作之后的磁盘 rootfs(包括 ext4、zfs 和 btrfs 等等)。 ramfs 和 tmpfsramfs 只是一个简单的文件系统,用作一阶段 rootfs 的文件系统类型,它与磁盘文件系统最大的区别就在于 它没有可供回写的后备设备 ,以 Linux 6.12 内核版本为例(下同),其 ramfs 的代码实现: 1234567891011/* fs/ramfs/file-mmu.c */const...

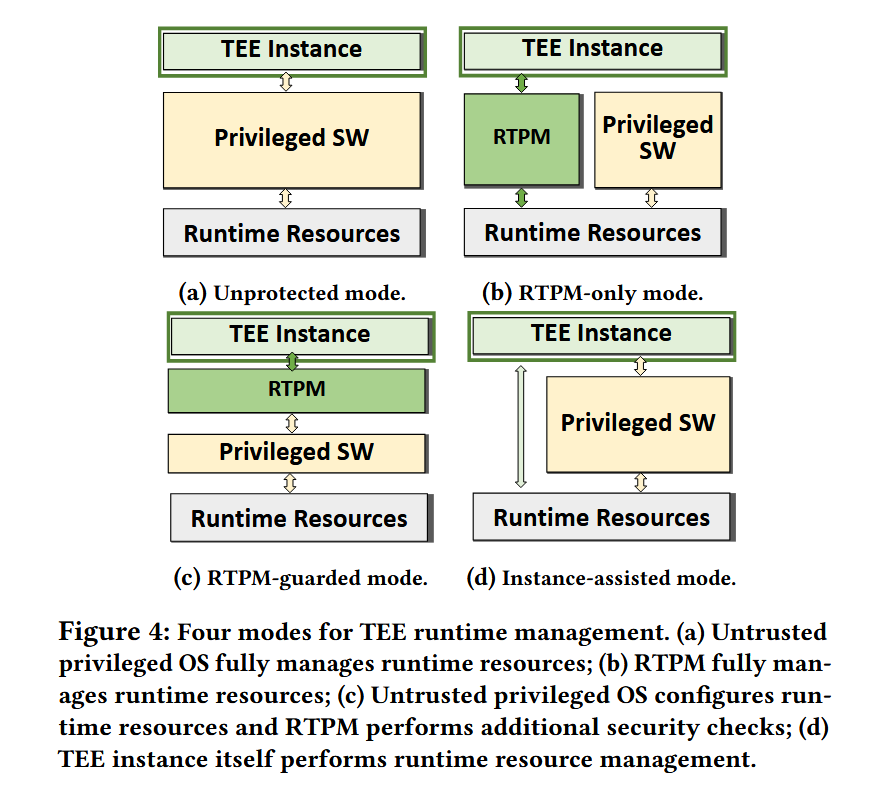

论文《SoK:Understanding Designs Choices and Pitfalls of Trusted Execution Environments》总结

本文将分享发表在 AsiaCCS ’24 上的论文《SoK: Understanding Designs Choices and Pitfalls of Trusted Execution Environments》,文章系统梳理了不同可信执行环境(TEE)设计上的选择和取舍,个人读完之后很有收获,推荐想做或正在做 TEE 设计相关工作的阅读。 TEE 设计核心挑战文章提出了 TEE 设计过程中的核心挑战:TEE 设计如何保护 TEE 实例使用的资源,同时使不受信任的(宿主机)操作系统能够以有效的方式管理计算资源,以履行 CSP 的职责。 简而言之,就是如何平衡安全隔离和高效性能之间的关系。举个极端的例子,我们可以将虚拟机启动、vCPU 调度、内存分配、异常处理等不可信 hypervisor 的工作完全交给新引入的位于 TCB 中的可信实体(文中称之为 RTPM, TEE Runtime Protection Module)来完成,这样会导致一些问题:在 RTPM 中实现宿主 hypervisor 中复杂的调度策略是不现实的。首先,像 AMD SEV 它的 RTPM 为安全协处...

使用QEMU调试Linux内核

本文是一个快速记录,旨在记录使用 QEMU 调试 Linux 内核的方法,文章内容比较短,内容也比较浅显,不会对具体原理进行分析,主打一个够用。使用的 QEMU 版本为 6.2,Linux 内核版本为 5.10,指令集架构为 x86_64。 使用 monitor使用 monitor 的前提是要先启用该功能,一般将其设置在指定的 telnet 端口(如 6789): 1-monitor telnet:localhost:6789,server,nowait,nodelay 使用 monitor 调试的基本场景是内核 crash 时,打开 QEMU 的 monitor,打印此时的寄存器值。为了保证 RIP 的值准确,需要在 QEMU 模拟器的内核命令行参数中关闭内核地址空间随机化: 1-append "nokaslr" 打开新的终端使用 telnet 连接到指定端口: 123456789101112131415161718192021222324252627282930313233343536373839$ telnet localhost 6789Trying...

使用QEMU安装并启动一个Ubuntu发行版

之前自己编译 QEMU 跑模拟器/虚拟机基本都是跑的一个基于 buildroot 构建的小型根文件系统,虽然也能够完成一些基础的测试,但是功能完备性上相比发行版来说还是要差很多,而且如果想添加新的软件环境也比较麻烦。因此这两天花了点时间倒腾了一下环境,把 QEMU 安装和运行发行版的流程走通,便于后续的学习和研究。 安装系统发行版我选择的是 Ubuntu,没有什么别的原因,只是因为用的最多。而已经安装好 Ubuntu 系统的磁盘镜像可能不太好找(官网只看到 RISC-V 架构有 pre-installed 版本),因此我选择下载 iso 镜像,然后手动安装。这里可以直接选择通过清华镜像源下载: 1wget https://mirrors.tuna.tsinghua.edu.cn/ubuntu-releases/noble/ubuntu-24.04.3-live-server-amd64.iso 我下载的是较新的版本,因此 seabios 可能不支持,需要更现代的固件,虚拟机场景下通常是 OVMF,使用包管理工具安装一下: 1sudo apt install ovmf 找到安装好...

QEMU训练营2025专业阶段实验解析

本人的研究方向主要是操作系统与虚拟化,平时接触最多的开源项目除了 Linux 内核外,便是 QEMU 了,不只是将它作为一个全系统模拟器和 VMM 来使用,还涉及到基于它的增量开发的工作。但这些基本都还是边做边学的,主要原因在于市面上一直缺乏系统性介绍 QEMU 的书籍和资料(我知道的仅有一本《QEMU/KVM 源码解析与应用》,但其主要专注于 QEMU 的 VMM 用途,对模拟器的介绍不是重点)。得知 OpenCamp 将举办 QEMU 训练营,我也是在持续关注,并且在第一时间报名并开展了学习。 截至现在,我已经完成了基础阶段和专业阶段的学习,正在等待项目阶段的开放。本文将分享我专业阶段实验的解题思路和方法,作为个人的一个记录,也为后续参与训练营的同学提供参考。 实验概述专业阶段的实验平台是由训练营主办方专门设计的一个简易的教学用板卡 G233,对它的介绍可以参考文档:b. G233 Datasheet - Learning QEMU Docs。 实验共有十个,归类下来总共有三类:lab1 主要是根据手册的说明,补全对 G233 板卡的模拟代码;lab2 ~ lab5 则是为...